Notice

Recent Posts

Recent Comments

Link

| 일 | 월 | 화 | 수 | 목 | 금 | 토 |

|---|---|---|---|---|---|---|

| 1 | 2 | 3 | ||||

| 4 | 5 | 6 | 7 | 8 | 9 | 10 |

| 11 | 12 | 13 | 14 | 15 | 16 | 17 |

| 18 | 19 | 20 | 21 | 22 | 23 | 24 |

| 25 | 26 | 27 | 28 | 29 | 30 | 31 |

Tags

- 기울기 소실

- 단층 퍼셉트론

- c++

- 베버의 법칙

- dl

- OpenGL

- 순방향 신경망

- 손실 함수

- BOJ

- deep learning

- 3d

- union-find

- 백준

- 계단 함수

- 딥러닝

- 베르누이 분포

- feedforward neural network

- vanishing gradient

- 범용 근사 정리

- 동적계획법

- 이진분류

- Perceptron

- DP

- bfs

- 경사하강법

- 알고리즘

- dijkstra

- 이진 분류

- 과대적합

- 다익스트라

Archives

- Today

- Total

Hello COCOBALL!

[DL] 순방향 신경망(Feedforward Neural Network) 본문

순방향 신경망

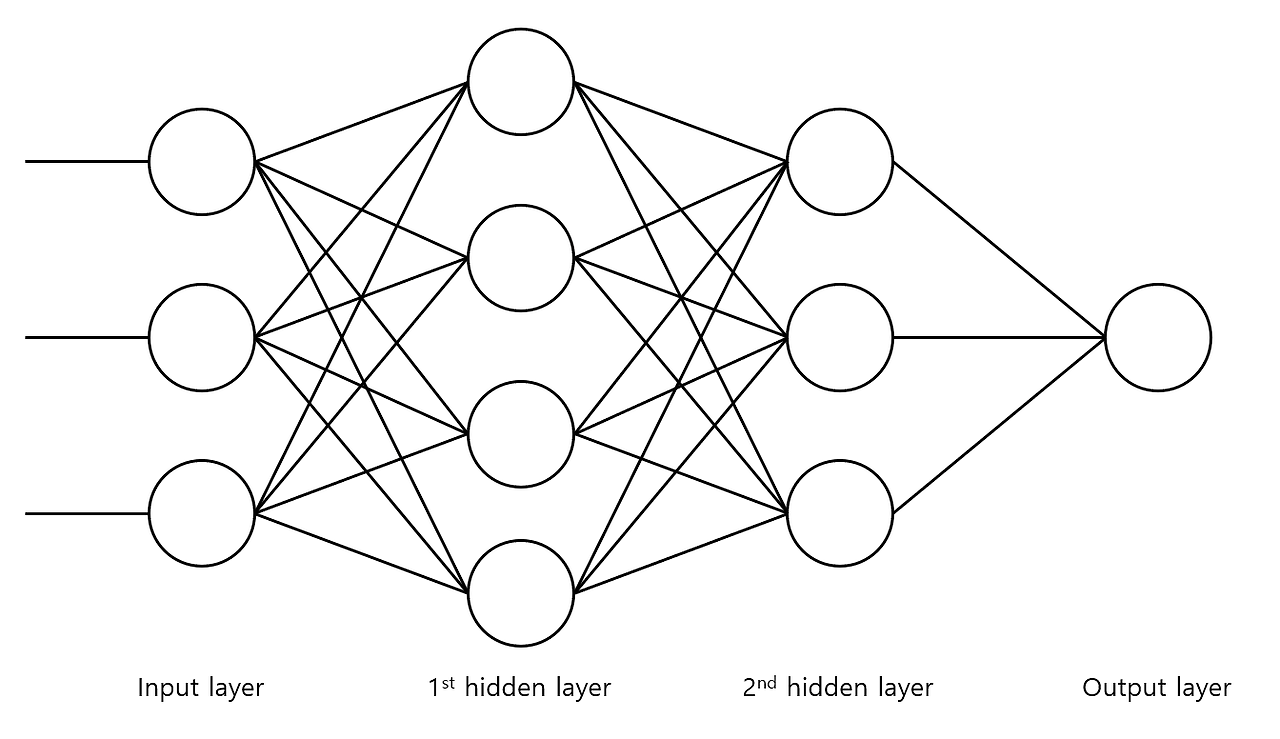

순방향 신경망은 가장 기본적인 형태의 인공 신경망이다. 입력층, 은닉층, 출력층으로 구분되며 입, 출력층은 각각 하나씩 존재하지만 입력층과 출력층 사이에 있는 은닉층은 문제의 복잡도에 따라 가변적으로 구성된다. 계층이 2~3개 정도로 구성되어 있으면 얕은 신경망(Shallow Neural Network), 그 이상인 경우에는 깊은 신경망(Deep Neural Network, DNN)이라고 한다.

1. 입력층 : 외부로부터 입력 데이터를 받아들임.

2. 은닉층 : 데이터의 특징을 추출.

3. 출력층 : 추출된 특징을 기반으로 추론한 최종 결과 출력.

순방향 신경망은 모든 계층이 완전 연결 계층(Fully Connected Layer)로 구성된다. 각 계층에 속한 모든 뉴런들이 이전 계층의 모든 뉴런과 연결되어 있는 구조를 의미하고, 이러한 구조로 인해 같은 입력 데이터로부터 각 뉴런에서는 다른 특징을 추출하는 것이 가능하다. 그러므로, 특징이 많은 데이터일수록 뉴런의 개수가 충분해야 데이터에 포함되어 있는 특징들을 모두 추출할 수 있다.

데이터에 내제된 특징을 추출하기 위해서는 가중 합산과 활성화 함수의 두 단계를 거치게 된다.

가중 합산은 추출할 특징에 중요한 영향을 미치는 데이터를 선택하는 과정이고, 특징 추출에 영향이 큰 데이터일수록 큰 가중치 값을 가지고, 반대의 경우에는 작은 가중치 값을 가진다.

활성화 함수는 원하는 형태로 특징을 추론하기 위해 데이터를 비선형적으로 변환하는 과정이다(ReLU 등).

'Deep Learning' 카테고리의 다른 글

| [DL] 범용 근사 정리(Universal Approximation Theorem) (0) | 2024.06.25 |

|---|---|

| [DL] 회귀(Regression), 분류(Classification) (0) | 2024.06.25 |

| [DL] 손실 함수(Loss Function) (0) | 2024.06.23 |

| [DL] 기울기 소실(Vanishing Gradient) (0) | 2024.06.23 |

| [DL] 활성화 함수(Activation Function) (0) | 2024.06.23 |